HBM(고대역폭 메모리)은 왜 AI 메모리일까?

인공지능(AI) 계산은 수학의 행렬 계산인데요. 컴퓨터의 CPU보다는 병렬계산에 특화된 GPU를 사용합니다. 하지만 일반메모리를 사용하게 되면 GPU의 병렬계산 속도를 따라가지 못합니다. 그래서 병렬계산에 맞게 설계된 고대역폭 메모리인 HBM을 사용해야 합니다.

인공지능 서비스의 성능을 좌우하는 것은 GPU보다는 메모리라고도 볼 수 있는데요. GPU의 성능이 좋아질 때 점점 더 많은 데이터를 빠르게 처리하려면 HBM은 그만큼 고성능이 요구됩니다.

5세대 HBM의 승리는 누구에게?

GPU 프로세서는 엔비디아에서 주로 생산하고요. 메모리인 HBM은 SK하이닉스, 삼성전자, 마이크론에서 생산합니다. 세 개 업체가 경쟁을 하며 아직은 SK하이닉스가 HBM의 최강자라고 볼 수 있는데요. 미국에서는 마이크론에 지원을 해주려고 하는 것 같고, 삼성전자는 12H를 개발하여 기술력으로 보면 삼성전자가 앞서는 것 같습니다.

앞으로 HBM 업체의 주도권은 양산과 수율에서 누가 더 잘 만드는지에 따라 결정될 것으로 보입니다.

최근에 마이크론이 엔비디아에 HBM을 공급할 것으로 보였으나 SK하이닉스가 먼저 납품하기로 결정되었다고 합니다.

또한 엔비디아 개발자 콘퍼런스에서 CEO인 젠슨황은 블랙웰 기반의 차세대 AI 칩인 ‘B100’을 공개했는데요. 젠슨황은 삼성전자의 HBM을 테스트 중이라며 기다가 크다고 밝혔습니다. 아마 성능 좋은 삼성전자의 HBM3E 12H 칩에도 좋은 소식이 있을 것으로 보여집니다. 이에 따라 삼성전자의 주식도 좋은 흐름을 보이고 있습니다.

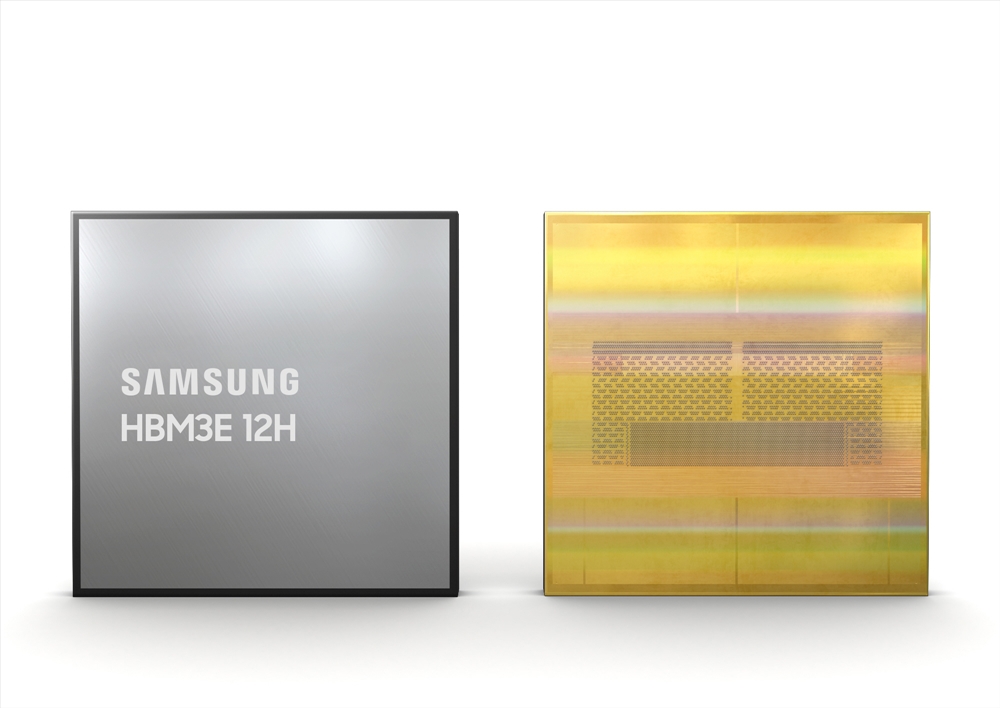

삼성전자 HBM3E 12H

삼성전자가 지난 2월27일 HBM3E 12H을 세계 최초로 개발했는데요. 이것은 5세대 HBM인 HBM3E를 12단(12H) 적층 구조로 쌓아 올린 기술입니다.

HBM3E 12H는 최대 초당 1,280GB의 대역폭과 현재 존재하는 최대 용량인 36GB를 제공하여 용량과 성능 모두 전작인 4세대 HBM인 HBM3 8H(8단 적층) 대비 50% 이상이 개선된 제품입니다.

HBM3E 12H의 속도는 1,024개의 I/O(입출력 통로)에 최대 초당 10Gb의 속도를 지원합니다. 이것은 초당 1,280GB를 처리할 수 있는 속도인데요. 1초에 30GB의 용량 UHD 영화 40여편을 다운로드 할 수 있는 속도입니다.

HBM3E 12H는 8단 적층 제품인 8H와 동일한 높이를 구현하였는데요. 열압착 비전도성 접착 필름(Advanced TC NCF) 기술로 HBM의 패키지 규격을 만족시켰습니다.

AI메모리 라고도 불리는 HBM은 이번에 새로 개발된 HBM3E 12H가 공개되면서 최근 급속도로 개발되고 있는 AI 플랫폼에서 사용되는 다양한 기업들에 최고의 솔루션이 될 것이라고 기대됩니다.

HBM이란 무엇일까?

HBM (High Bandwidth Memory) 고대역폭 메모리는 고성능 컴퓨팅, 그래픽스 프로세싱, 네트워킹, 그리고 서버와 같은 분야에서 사용되는 최신 메모리 기술입니다. HBM은 기존 메모리 솔루션들에 비해 뛰어난 대역폭, 더 낮은 전력 소모, 그리고 더 작은 형태 인자를 제공합니다. 이러한 특성은 데이터 중심 애플리케이션의 성능을 향상시키는 데 핵심적인 역할을 합니다.

HBM의 특징

높은 대역폭: HBM은 여러 개의 메모리 다이를 수직으로 쌓고, 실리콘 관통 전극(TSV)과 마이크로 범프를 이용해 연결함으로써 높은 데이터 전송 속도를 달성합니다. 이 구조는 메모리와 프로세서 간의 통신 대역폭을 크게 늘려, 훨씬 더 빠른 데이터 처리 속도를 가능하게 합니다.

에너지 효율성: HBM은 더 낮은 전압에서 작동하고, 데이터 전송을 위한 짧은 경로 덕분에 기존 메모리 솔루션들에 비해 에너지 효율이 뛰어납니다. 이는 특히 에너지 소비를 크게 줄여야 하는 모바일 장치나 데이터 센터에서 중요합니다.

형태 인자: HBM은 3D 스택 메모리 기술을 사용하여, 더 적은 공간을 차지하면서도 더 많은 메모리 용량을 제공합니다. 이는 장치의 전체 크기를 줄이는 데 도움이 되며, 특히 공간 제약이 있는 애플리케이션에서 유용합니다.

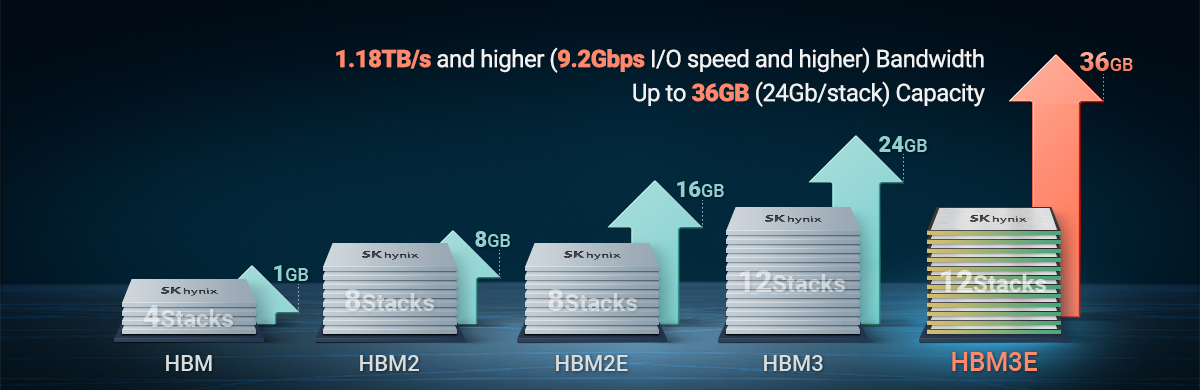

HBM의 세대

HBM1: HBM 기술의 첫 번째 버전으로, 최대 128GB/s의 대역폭을 제공합니다.

HBM2: HBM1에 비해 향상된 용량과 속도를 제공하며, 대역폭은 최대 256GB/s에 이릅니다.

HBM2E: HBM2의 확장 버전으로, 더 높은 용량과 최대 460GB/s의 대역폭을 제공합니다.

HBM3: HBM2E보다 더 향상된 대역폭과 용량을 제공합니다. 최대 819.2GB/s 의 대역폭을 제공합니다.

HBM3E: 최근에 개발된 가장 최신 버전입니다. 대역폭은 최대 1.15TB/s으로 HBM3보다 획기적인 개선된 성능을 보여줍니다.

HBM 기술은 특히 고성능 그래픽스 카드, 서버, 슈퍼컴퓨터, 그리고 인공 지능(AI) 및 머신 러닝(ML) 애플리케이션에서 그 가치가 높게 평가되고 있습니다. 이 기술은 계속해서 발전 중이며, 미래의 컴퓨팅 요구를 충족시키기 위한 중요한 역할을 할 것으로 예상됩니다.

'엔지니어링 > 과학 SCIENCE' 카테고리의 다른 글

| 연세대학교 전파망원경 소개 - 연세대학교 천문대(한국우주전파관측망 연세전파천문대) 영상 첨부 견학 신청 방법 (0) | 2025.03.24 |

|---|---|

| 미국 매미 떼의 습격 매미의 생장 성장 주기 매미의 유해성 매미겟돈 (1) | 2024.04.29 |

| OpenAI Sora 소라 AI가 영상 업계 종사자를 위협하기 시작했습니다 (33) | 2024.02.18 |

| 오로라 발생의 원리 관측할 수 있는 지역 역사 (49) | 2024.02.14 |

| 태양 극대기란 대비 방법 역사 흑점 폭발 (0) | 2024.02.13 |

댓글